Moin!

Was heißt Bildausschnitt falsch gewählt? Ich starte das Video und habe die Lok darauf. Der Himmel ist schön blau und wölken sind zu erkennen. Während der Aufnahme wird innerhalb von 2 Sekunden der Himmel komplett grau... beziehungsweise beim Anschauen wegen HDR grell weiß

@Wuchtbrumme hat es ja schon angerissen, aber als Ergänzung dazu: Physik ist halt ein A-Loch.

Mal ein wenig vereinfacht dargestellt: Sagen wir, dass echte Helligkeitsspektrum geht von 0 (ganz dunkel) bis 100 (sehr hell). Eine bessere DSLx-Kamera kann davon z.B. einen Bereich von 60 Punkten abdecken. Das iPhone von mir aus 40 Punkte (Relationen vollkommen frei aus dem Hut gegriffen, das System soll verdeutlicht werden).

D.h., wenn du nun ein Bild hast, dass von max. Dunkelheit bis maximaler Helligkeit alles enthält, wirst du nicht alles gleich "gut" (=umfangreich) abbilden können, sondern musst dir überlegen, wo du deine 40 Punkte "verteilst" (was nur am Stück geht). Du könntest also den Fokus auf den Bereich 0-39 legen => dunkle Bereiche würde man jetzt super differenzieren können, aber alles helle würde dir "ausbrennen".

Du könntest auch 61-100 wählen: Jetzt sind helle Bereiche differenziert - aber alles was dunkel ist, vermischt sich zu einem großen undifferenzierbaren Dunkel.

Wählst du etwas in der Mitte, verlierst du in den äußeren Randbereichen etwas - und zwar sowohl im Dunklen, wie im Hellen.

Und das ist auch der Effekt, den du super auf deinen Bildern siehst: Als du anfängst, sieht man noch größere Abstufungen in den Wolken. In diesen sieht man noch hellere und dunklere Bereiche, mehr Struktur etc. Wenn du dir aber die Lok anschaust, verlierst du da in den dunklen Bereich alles, es sind keine Details mehr erkennbar, alles "vermischt".

Dann wird nachgeregelt: Das iPhone "interpretiert", durch Analyse des Bildes, der Farbverteilung, der Dynamik etc., dass du wohl die Lok (oder vielmehr: den dunkleren Bereich) abbilden willst. Also verschiebt es dein Spektrum. Jetzt beginnst du Details im Dunkeln zu erkennen. Die Verstrebungen werden sichtbarer, Details die vorher untergegangen sind, tauchen auf. Nachteil: Aufgrund des überschaubaren Dynamikumfangs geht dir nun der helle Bereich verloren.

Es ist letztlich simple Physik und du kannst sie nicht ändern. Es gibt zig Möglichkeiten, damit umzugehen oder es zu kompensieren. HDR ist einer dieser Wege - aber er kann nur die Grenzen ausweiten, nicht außer Kraft setzen. Dazu kommt sowas wie Perspektivenwechsel, ändern der (äußeren) Umstände (z.B. Belichtung, ...).

Ich habe hier eine Sony A7 III S rumfliegen, die mal eben über 4.000 Euro kostet und eine Canon EOS M50 M2 für irgendwas um die 700 Euro und beide zeigen - natürlich! - den gleichen Effekt. Wie eingangs dargestellt, zwar mit größerer Abdeckung insgesamt, aber dennoch kann ich nicht vom Flutlicht bis zum dunklen Höhleneingang beides gleichzeitig im Bild haben und dennoch alle Details erkennen.

Je nach Kamera-/Video-App kannst du den Bereich festlegen, der für die Belichtungsmessung genommen werden soll, aber den o.g. Effekt wirst du nicht verhindern können.

Moin!

Und noch einen Nachtrag dazu: Du kannst dir das auch wunderbar visualisieren, indem du dir mal das Histogramm der Bilder anschaust.

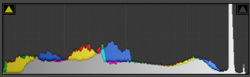

Hier das von Bild 4 - dem "hellen" mit dem ausgebrannten Himmel:

Hier siehst du sehr schön den Balken ganz rechts - das ist der ausgebrannte Himmel, wo einfach alles "durch die Decke" schießt und nicht mehr erkennbar ist.

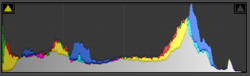

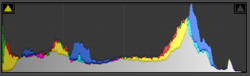

Umgekehrt bei Bild 1, dem mit dem "besseren" Himmel:

Hier sind die hellen Farben (rechte Seite in der Grafik) nicht mehr übersteuernd, gehen zwar hoch, aber schießen nicht raus und generell läuft der Graph zum Ende hin eher aus. Dafür im dunkel Bereich (ganz links): Hier geht der Graph schon "recht hoch" los, d.h. es gibt dunkle Bereiche, die nicht mehr erkennbar sind (="absaufen").

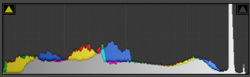

Übrigens gibt es auch verschiedene Kamera-Apps, die nicht nur ein Histogramm anzeigen, damit man schon einen Eindruck hat, ob man im "guten" Bereich unterwegs ist. Es gibt auch welche, die Live ein Ausbrennen der Farben anzeigen. Hier mal ein Beispiel mit der Lightroom-Foto-App. Da leuchtet einfach eine Lampe stark gegen eine Wand:

Der "schraffierte" Bereich wird direkt in der Liveansicht durch die App so dargestellt und zeigt das "Ausreißen" der hellen Bereiche, also das hier keine Differenzierung mehr gegeben ist sondern alles einfach nur noch "weiß" ist.